Appleは8月5日(米国時間)に、iPhoneやiPadの児童ポルノ画像を検出することが出来る新機能を、iOS15で搭載することを発表しました。

児童ポルノの被害者からしてみれば、助け船になる新機能の発表でした。

しかし、実現することは叶わなくなりました…。

それはなぜか。

本記事では、「Appleが児童を守るために作っている機能の話」「導入時期が無期限延期になった理由」「今後の導入時期の話」の3つについて詳しく解説していきます。

そもそもの機能がよくわかっていない方で、詳しく知りたい方は別の記事で解説していますので、そちらをご覧になってからこっちの記事をご覧いただいた方が分かりやすいです。

https://m32006400n.xsrv.jp/infrastructure/will-apples-latest-technology-prevent-child-pornography-and-invade-privacy/

児童ポルノ画像を特定する新機能が問題へ

Appleは、2021年9月3日(アメリカ時間)に、児童を守る為の新機能の導入について延期を発表しました。

新機能は、今年の秋頃に導入されるiOS15にて搭載することを発表していました。

児童を守る為に計画されていた新機能は、主に3つの機能があります。

新機能の3つの機能

- iCloudのアップロードされた児童ポルノ画像を特定できる機能

- メッセージアプリで性的写真を送受信するときに子と親に警告する機能

- Siriと検索で児童ポルノに該当するコンテンツの検索について注意を促す機能

今回のAppleが計画していた「3つの新機能の詳細な説明」に関しましては、別の記事で詳しく解説していますので、そちらをご覧ください。

Appleの名目としては、児童ポルノの被害者になっている子どもの被害を最小限に抑えることを目的とし、新機能の搭載を準備していました。

しかし、重大な問題を抱えている可能性があるのでは?という多くの意見もあり、無期限の延期を発表する運びとなりました。

Update as of September 3, 2021: Previously we announced plans for features intended to help protect children from predators who use communication tools to recruit and exploit them and to help limit the spread of Child Sexual Abuse Material. Based on feedback from customers, advocacy groups, researchers, and others, we have decided to take additional time over the coming months to collect input and make improvements before releasing these critically important child safety features.

引用元:Apple公式ホームページ「Expanded Protections for Children」

要約すると、「性的虐待から児童の保護をするために、新機能(児童ポルノ画像の検出など)の計画を発表したが、お客様、擁護団体、研究者などから意見を多くいただいたので、今後数か月にわたって改善を行うことにしました。」ということです。

児童ポルノの被害者を減らす人の為になる機能が、なぜ無期限延期になったのでしょうか?

Appleが児童ポルノ写真のスキャン導入を無期限延期にした理由

結論、「プライバシーの問題」「悪用されてしまうケース」「写真特定のシステムに欠陥がある疑惑」の3つの理由があると有識者や団体、個人の声により、Appleは児童ポルノ写真のスキャン機能などの導入を無期限延期にしました。

じつは、発表当初から「”児童を守る”という目的はいいけど、問題山積みだよね」とは色々な有識者や権利保護を主張する団体から言われていました。

Whether they turn out to be right or wrong on that point hardly matters. This will break the dam — governments will demand it from everyone.

And by the time we find out it was a mistake, it will be way too late.

— Matthew Green (@matthew_d_green) August 5, 2021

上のツイートは、ジョンズ・ホプキンス大学のサイバーセキュリティ研究者であるマシュー・グリーン氏のツイートになります。

マシュー・グリーン氏は、Appleの児童ポルノ画像のスキャンに関して、「悪いアイディア」というように言及しており、児童ポルノ画像のスキャンが及ぼす危険性について話をしています。また、アップルは監視する理由と対象をより明確にすべきという考えがあるようです。

他にも、自由な言論の権利を保護する目的を持つ団体のである「電子フロンティア財団(EFF)」や、インターネットをオープンで監視のない状態に保つために活動を行っている「Fight for the Future(FFTF)」「OpenMedia」もAppleに対して、iPhoneの監視をすることを辞めるように声を上げています。

すでに、「電子フロンティア財団(EFF)」には、50,000人の署名が集まっていて、「延期ではなく、中止を求める」内容を2021年9月8日(アメリカ時間)に提出する予定とのことです。

多くの方が、iPhoneをスキャンすることを危険であり、ワンチャン個人の自由が抑圧されてしまうと考えられています。

なぜなら、3つの問題点があるからです。

プライバシーの問題

結論、「iPhoneのスキャンによる、すべてのiCloud写真ユーザーのプライバシーの侵害」「セキュリティレベルの低下による個人情報流出の危険」の2つです。

Appleは、「iCloudのアップロードされた児童ポルノ画像を特定できる機能」はiCloudにアップロードした写真にのみ適応され、「メッセージアプリで性的写真を送受信するときに子と親に警告する機能」は保護者からオンオフすることが可能という発表していました。

Appleは、児童ポルノ画像と認識されるものをプログラムで特定し、その後は本当に正しいかどうかを人の目でチェックをすることで誤りが無いようにすると明言していました。

しかし、iCloud Photoの中身を常時スキャンすることには変わりがありません。

プライバシー保護の観点から見て、個人や家庭内の私事・私生活のデータである写真を、他人(Apple)から干渉・侵害を受けないようにするのは、当然のことであり、人としての権利です。

日本人的には、やましいことや悪い事をしてないなら見せられるよね?っというのはありますが、プライバシー保護や権利の観点からみると、そんな話は通りません。

個人の情報を他社に公開することに関しては、あくまで任意であり、当事者の承諾が必要になってきます。

もちろん、国ごとによって考え方は異なりますが、もし法治国家で実装されるのであれば、iCloud Photoの利用に関して新しく許可や承諾を取らなければいけなくなります。

また、メッセージアプリの新機能は、性的写真を送受信する際に、子と親に通知が入るようになります。親は通知をオンオフすることができますが、性的写真やコンテンツをチェックする際は、ユーザーのプライバシーを保護する暗号化(エンドツーエンド)を侵害する危険性があります。

どういうことかと言いますと、本来メッセージというのは、送信者と受信者以外は見れないようにすべき内容であって、第三者が内容を知る行為はあってはなりません。

第三者に知られないのが、個人のプライバシーや人権を守るためにはとても重要になってきます。その点を、守るのがエンドツーエンド暗号化になってきます。

エンドツーエンドとは、通信サーバーがメッセージデータを読み取ることができず、当事者間でしかメッセージを読み取れない暗号化の方式を言います。

Appleは、過去から現在に至るまで、iPhoneユーザーなどの個人情報をどんなことがあっても守ってきました。

例えば、2019年12月に米フロリダ州ペンサコーラで発生した銃乱射事件では、犯人のiPhoneロック解除については拒否したことが有名です。どんな人間であろうとも、プライバシーの保護に努めたと言えば聞こえがいいでしょうか。ってか、エンドツーエンド方式の暗号は外部から開けないような仕組みだから、Apple自身も開けることができなかったんですけどね💦

しかし、今回のメッセージアプリの新機能は、外部から干渉できる仕組みを搭載しようとしています。

第三者が見れる機能(外部から干渉できる機能)を実装すると、同じサーバーにメッセージの大部分の内容に関する情報を公開するため、そこから情報の流出や予期しない問題に発展する可能性があります。もちろん、この機能を一般家庭内で留められればいいのですが、機能を悪用しようとするものは一定数いるでしょう。

子どもだから、正常な判断や適切な判断をすることは非常に難しいという理由はわかります。自分の陰部の写真を送ってしまう子どももいるでしょう。

正直、児童ポルノに関する問題は今後取り組んでいかない重大なこと。

ですが、「iCloudのスキャン」「メッセージアプリの完全なエンドツーエンドを辞める」方法自体に問題があり、すべてのiPhoneやiPadユーザーのプライバシーを侵害してしまう可能性があることが問題になっています。

悪用されてしまうケース

批評家や評論家は、国によっては、政治利用や軍事利用されるケースを懸念しています。

要は、本来の目的とは違った使い方を国ごとでされてしまうのでは?という心配ですね。

例えば、本来は児童ポルノ画像を特定するツールだが、児童ポルノ画像ではなく、特定の政治家の写真に対象を変化させることができるのであれば、独裁政権にとって不都合な人間を選別できるツールにもなるとも言えます。

Appleは「絶対にしない」と否定していますが、国ごとで将来的にどんな対応になっていくかはまだわかりません。法律が変われば、Appleも対応をしていかなければならなくなるでしょう。

「絶対にしない」ってことは技術的にはできるってわけでしょ?個人の発言や思想の自由が侵害または弾圧されてしまうのでは?っと心配しているユーザーは一定数います。

写真特定のシステムに欠陥がある疑惑

Appleの児童ポルノ画像を検出する新機能は、誤って認識される可能性が高いのでは?という疑惑を専門家は抱いています。

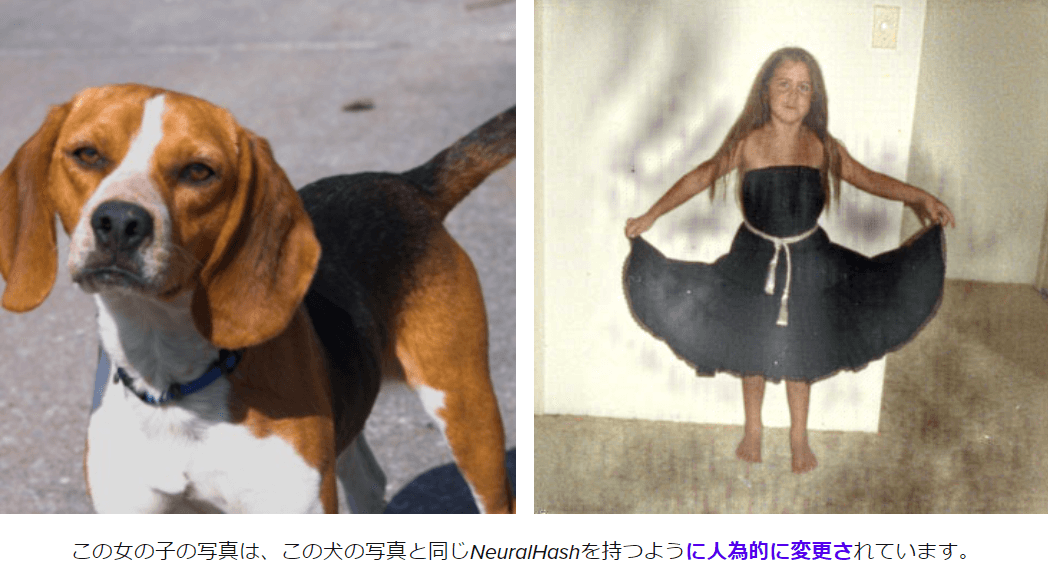

「neuralMatch」と呼ばれる、児童の性的虐待の既知の画像を検出するように設計されたツールのもとになる技術は「NeuralHash」と呼ばれ、画像を分析し、コードに変換をすることで、児童ポルノ画像(CSAM)のコードと、一致しているかどうかを判別して、有害かどうかを判定します。

しかし、必ずしも正しい答えをだすわけではありません。

実は、Facebookが過去に同じようなシステムを使って、全裸などの性的コンテンツを取り締まろうとした際に、誤ってリトルマーメイドなどの有名な彫像の写真が削除してしまったことがあります。

もちろん、Appleも間違いがあるのは承知の上で、システムが100%じゃない事を明言しています。

Appleは、間違える確率は1年間で0.000000000001%と言っていますが、研究者たちは実際もっと起こりえる可能性があるのでは?と疑惑を抱いています。

Appleの使用する予定の画像をコードにして、別の写真と似ているかどうかを判別するシステムに使われる技術は、上の画像の「犬」と「少女」を同じとして認識してしまうからです。

上記の2つの画像は、少女の画像を編集して、犬の画像のコードと似せて作成しているので、同じように検出されてしまうのは当然と言えば当然なのですが、全く内容の違う写真であっても誤った判断をプログラムがしてしまうことや画像を偽装することは可能ということがわかります。

また、研究者はデータベースが本当に正しいのかどうか第三者機関からの圧力があった場合、システムが正しく使われないのでは?と懸念しています。

児童ポルノの対策は今後いつ導入される?

Appleが「子供の安全機能をリリースする前に、今後数か月にわたって入力を収集して改善するためにさらに時間をかけることにしました。」と明言している内容から推察するに、年内のリリースは可能性が低いと考えられ、2022年中にリリースすることを現在の目標として動いていると思われます。

予想としては、1年以内。来年の新型iPhoneの発売までには「iCloudのアップロードされた児童ポルノ画像を特定できる機能」「メッセージアプリで性的写真を送受信するときに子と親に警告する機能」の新機能が実装されるのでは?と思いますが、識別の方式を変えない限り、多くのユーザーは反発を続けるでしょう。

まとめ

Appleは、iPhoneやiPadの児童ポルノ画像を検出することが出来るなどの子どもを守る為に開発しているシステムについて2021年9月3日(アメリカ時間)に無期限延期を発表しました。

理由は、性的虐待から児童の保護をするために、新機能(児童ポルノ画像の検出など)の計画を発表したが、お客様、擁護団体、研究者などから意見を多くいただいたので、今後数か月にわたって改善を行うことにしました。

なぜ、お客様、擁護団体、研究者などは、Appleに意見をしたのでしょうか。

具体的な理由は3つです。

延期になった3つの理由

- プライバシーの問題

- 悪用されてしまうケース

- 写真特定のシステムに欠陥がある疑惑

目的自体は素晴らしいと思いますが、システムの内容的に問題が山積みになってしまっている。だから、多くのユーザーがAppleに対して意見を言った。その結果、iOS15での実装ではなく、無期限の延期となりました。

今後、Appleが児童ポルノ画像(CSAM)を検出するシステムのリリースは未定になっていますが、「数か月」と言っているので1年以内には調整したシステムがリリースされる可能性が高いと思います。

この記事を気に入っていただけたら、コメントやシェアをしていただけるととても励みになります!これからも、iPhoneの最新情報やiPhoneのトラブル解決方法について情報発信していきますので、たまにサイトをチェックしていただけると、とっても嬉しいです(‘ω’)ノ。

SNSのフォローボタンを、ポチってくれるとめっちゃ嬉しいです👍

ではでは、最後までご覧いただきありがとうございました。

Twitter:@Uriuri_writer

Follow @Uriuri_writer

Instagram:@uriuri_writer

Instagram

コメント

[…] Appleが児童ポルノ写真のスキャン導入を無期限延期へ?理由と今後の導入時期について […]